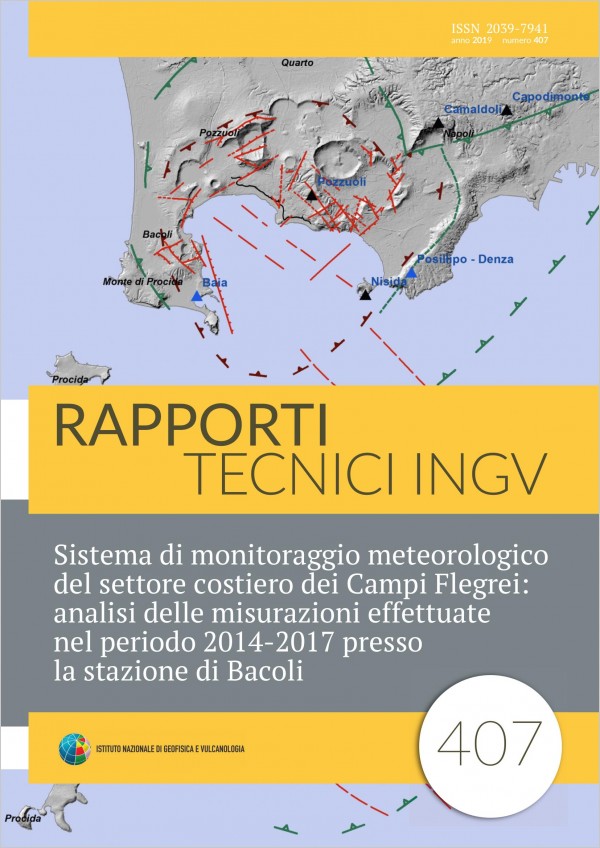

Sistema di monitoraggio meteorologico del settore costiero dei Campi Flegrei: analisi delle misurazioni effettuate nel periodo 2014-2017 presso la stazione di Bacoli

Vol. 407 (2019)

Two weather stations have been installed in the coastal region of the Municipalities of Bacoli (Lake Miseno-Case Vecchie) and Naples (Cape Posillipo-Denza Institute) within the frame of a cooperation between the INGVNapoli and IAMCCNR Napoli in a PON REC 20072103 project: "Innovative MONITORING for the Coasts and the Marine Environment (MONICA)". These stations have provided accurate measurements of various weather-climatic parameters (temperature, rainfall, wind, humidity, atmospheric pressure), with a time frequency of 10 minutes over a four-year period. This report documents the instruments used and the time series data recorded during the period 2014-2017 by the Bacoli meteorological station, and discusses the meteorological implications for the study area. The air-temperature trend in the analyzed period is characterized by two years with values close to their average and two years with significant deviations that reach their maximum during the summer season (2014, 2015). Rainfall values denote a remarkable irregularity, with monthly cumulative values sometimes extremely high (e.g. October 2015, September 2017), alternating with months with limited rain accumulation even in seasons during which rainfalls are generally copious (e.g. December 2015 and 2016). The pluviometric behavior of the western coastal zone of Campi Flegrei is characterized by frequent phenomena of short duration and high intensity that can trigger extreme hydrological and/or hydrogeological events. The wind regime appears substantially stable during the fouryear period, both in terms of anemoscopic regime (provenance direction), and average intensity. This highlights the influence of local morphological factors that are able to control the wind regime along the Campi Flegrei coastal zone.

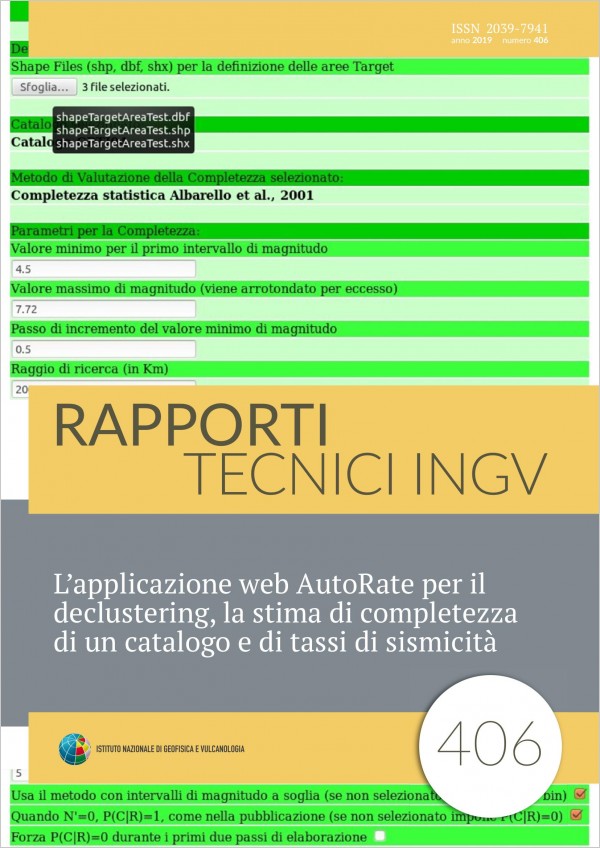

L’applicazione web AutoRate per il declustering, la stima di completezza di un catalogo e di tassi di sismicità

Vol. 406 (2019)

During the process for assessing seismic hazard there are some recurring operations which can be automated, which are about analysing the input data elements. The recurring operations are based on standard procedures and well known algorithms, and are performed a number of times in the range of tens, or even hundreds. It is therefore important to guarantee the correctness of the elaborations, and to reduce the human intervention which is always a potential source of errors. Specifically, we identified the following operations to be automated: the declustering of a catalog, the estimate of the catalogue completeness, the estimation of seismicity rates of source areas according to the Gutenberg-Richter distribution (G-R; [Gutenberg & Richter, 1944]). To perform the above operations, we developed a web application, AutoRate. The application allows to use databases (including geographical databases) shared between the users, to have the code always updated and available to all the users, to use shared dedicated resources to perform the elaborations removing the load on personal computers. The application offers the users to choose different approaches for each operation; additionally, it is explicitly designed to host new approaches. The output format of each type of operation is independent from the selected algorithm. Each output format is designed to allow a rapid and simple comparison and to be immediately usable as input for the computation of the seismic hazard.

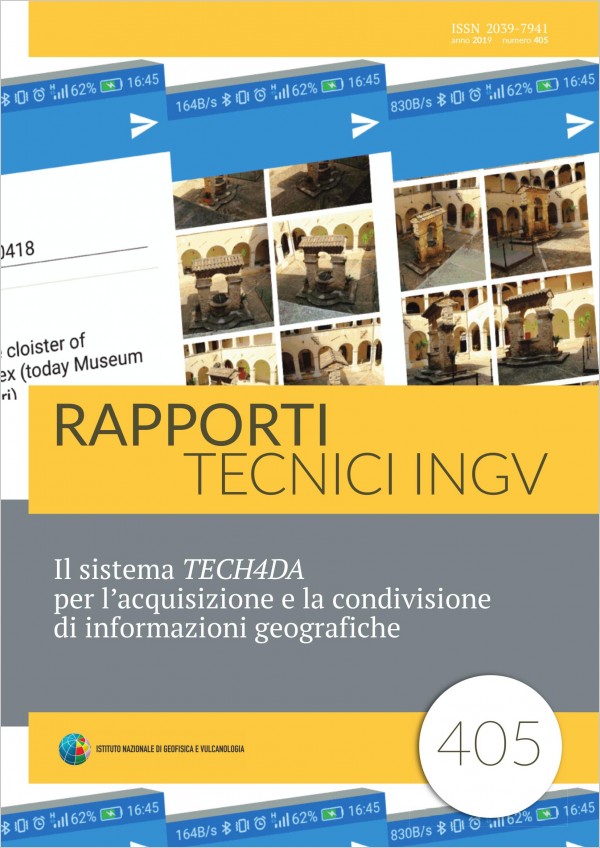

Il sistema TECH4DA per l’acquisizione e la condivisione di informazioni geografiche

Vol. 405 (2019)

The 2016-2017 seismic sequence that struck the Central Italy severely damaging different towns, it showed how the marks of our culture can be deleted in an instant. The TECH4DA system (acronym of Technologies for Damage Assessment) was developed both to preserve the photographic memory and support the survey activities after a disaster. TECH4DA is a semi-automatic system based on a client-server architecture optimized for the Android and iOS mobile devices. The capability to store location and aspect of the buildings in different time allow to assess their changes due to an earthquake. TeCH4DA can be used by expert involved in damage assessment, although it has been designed for obtaining relevant contribution also from the citizens. The active and widespread participation of the citizens makes TECH4DA a platform based on the crowdsourcing. The Central Italy seismic sequence showed the difficulty to understand the cumulative effect due to a series of earthquakes occurred at short temporal distances. The capability to interrelate an image and a description to each event makes possible to freeze the damage progression at a specific date, enabling, a progressive and comparable analysis of the effects of an earthquake. TECH4DA is part of the products developed in the framework of the PON MASSIMO project aimed to the monitoring of the cultural heritage in seismic area [Montuori et al., 2016], which integrates non-destructive and non-invasive surveys based on satellite, airborne and terrestrial sensors. In this report, the technical development of the TECH4DA system is described, in addition to client server logic and the modules which compose the infrastructure. Moreover, some applications and potential future developments are outlined.

Emergenza sismica nel centro Italia (2016-2017): le attività del Centro Operativo Emergenza Sismica (COES) e prospettive future

Vol. 404 (2019)

On August 24, 2016, a magnitude 6.0 earthquake, located between the towns of Amatrice, Pescara del Tronto, Arquata del Tronto and Accumoli, struck Central Italy, starting a long and complicated seismic sequence [GdL INGV sul terremoto di Amatrice, 2016]. Following the agreement signed by the Istituto Nazionale di Geofisica e Vulcanologia (INGV) and the Department of Civil Protection (in Italian Dipartimento di Protezione Civile - DPC from here on), and the actions defined in the draft protocol that the INGV is codifying to manage seismic emergencies, the Crisis Unit and the Emergency Operating teams SISMIKO, QUEST, EMERGEO, EMERSITO and IES have been immediately activated [Pondrelli et al., 2016]. The seriousness of the consequences of the event was immediately clear. A few hours after the beginning of the emergency, the Head of the DPC ordered the opening of the DPC Command and Control Direction (Di.Coma.C. from here on), that is the national coordination center for the Components of operational structures for Civil Protection in the area affected by the earthquake. The Di.Coma.C. was set up and activated in the morning of Sunday 28 of August in Rieti [Annex 1]. Also INGV was involved in this organization. On August 28, the Seismic Emergency Operations Center (in Italian: Centro Operativo Emergenza Sismica – COES from here on [Moretti et al., 2010a; Moretti et al., 2011; Moretti and Pondrelli, 2013]) was installed and immediately operational as the INGV outpost in the epicentral area. The COES was active at Di.Coma.C. until its closure, in April 7, 2017. In 8 months, 55 staff units from all the INGV offices took duty. The implemented organization showed a good efficiency, especially when a series of important new events, in October 26th and October 30th 2016, and in January 18th 2017, put the whole emergency system again under stress. In this report we describe the activities carried out by the COES, the pop-up problems, the adopted solutions, the positive results we obtained, with the aim to discuss a project aimed at improving this important part of the INGV management structure of a seismic emergency.

Evoluzione ventennale (1998-2018) del sistema Mag-Net per l’acquisizione dei segnali dalla rete magnetica dell’Etna e dell’isola di Stromboli

Vol. 403 (2018)

Nel 1997 esisteva già la rete magnetica del M.te Etna. Con il sistema Mag-Net [Del Negro et al, 1998, 1999, 2002] si è cercato di rinnovarla risolvendo i problemi fino ad allora aperti. I problemi maggiori riguardavano soprattutto la gestione dell’alimentazione e la continuità del dato. In commercio esistevano già sistemi pronti all’uso che richiedevano solo qualche adattamento però ritrovandosi con un sistema chiuso (black box) per cui l’evoluzione è pressoché impossibile [Sicali et al, 2016]. Si è scelto in alternativa di realizzare su un sistema completamente aperto, Mag-Net, assecondando una visione futuristica e di lungo periodo. Dalla progettazione primordiale si è passati alla sua realizzazione e successivamente a uno studio sistematico durato 20 anni, durante il quale si è cercato di valutare il sistema quando più oggettivamente è possibile. Negli anni si è arrivati a definire i tre concetti di stabilità, efficienza e automatismo [Sicali et al, 2016] che hanno permesso di far evolvere negli anni Mag-Net (figura 1) finché si è potuto ed arrivare a definire un nuovo sistema di acquisizione IDRA (Interactive Device for Remote Acquision) (figura 2) che risolvesse totalmente i problemi.

Software per la gestione del parco auto dell’INGV della Sezione di Catania - Osservatorio Etneo: progettazione e implementazione

Vol. 402 (2018)

Oggetto del presente report tecnico è la descrizione del nuovo software di gestione del parco auto, il principale strumento impiegato presso la sede dell’INGV-OE per la gestione delle attività relative all’utilizzo dei veicoli ubicati presso le sedi di Catania, Nicolosi e Lipari. Rispetto alla prima versione software [Mangiagli et. al, 2008] è nata la necessità di riprogettare il sistema di archiviazione, precedentemente basato su Microsoft Access®, nonché la volontà di poter sfruttare le potenzialità dell’HTML5 per la gestione dell’interfaccia web. Tecnologicamente, l’interfaccia rientra appieno nella concezione del cosiddetto “Web 2.0”, indirizzato allo sviluppo di un numero sempre maggiore di applicazioni fruibili via browser. Questa tecnologia è composta principalmente da una pagina HTML (HyperText Markup Language) arricchita da funzioni tipiche delle applicazioni desktop (pagina web dinamica). Attualmente i browser che supportano appieno tali funzionalità (basati principalmente sul linguaggio Javascript) risultano Firefox e Chrome. La nuova interfaccia web viene regolarmente utilizzata dal personale dell’INGV-OE a partire dal 1 Settembre 2015. La prima parte del report è volto alla descrizione del database preposto per l’archiviazione delle prenotazioni, dell’ubicazione e dell’appartenenza ai gruppi di ogni veicolo del parco auto. La seconda parte descriverà invece la struttura dell’interfaccia realizzata per l’accesso al suddetto database.

Un payload per drone: misure di temperature in ambienti ostili

Vol. 401 (2018)

La modalità tipica per condurre una misura da un mezzo aereo è quella contactless (senza contatto). Infatti per sua natura un velivolo è predisposto all’osservazione di grandi quantità di territorio, e l’indagine ottica (non necessariamente nel visibile) è quella privilegiata. Purtroppo l’indagine ottica ha la necessità di conoscere, almeno in alcuni punti necessari per la calibrazione, la ‘verità al suolo’ (ground truth, nel linguaggio del telerilevamento). Tipicamente si raggiunge il punto in questione con mezzi di terra e si effettuano misure a contatto. Questo non è possibile in particolari circostanze, quando l’oggetto della misura non è raggiungibile con mezzi di terra o, comunque, non è raggiungibile senza mettere a rischio l’incolumità dell’operatore. Questo è particolarmente vero sulla manifestazione idrotermale LuSi (nord-est dell’isola di Giava, Indonesia) dove una fuoriuscita di fango bollente, iniziata nel 2006, ed attiva ancora oggi, ha coperto 7 km² di territorio [Mazzini et al., 2007]. I crateri di LuSi (fig. 1), interessati da temperature intorno ai 100°C, non sono raggiungibili (la parte fluida ha un raggio di circa 200 metri intorno ai crateri) e il modo più sicuro di raggiungerli è un velivolo a controllo remoto. Il laboratorio LNTS (Laboratorio Nuove Tecnologie e Strumenti) della Sezione Roma1 dell’INGV ha partecipato al progetto europeo LUSILAB fornendo un drone dotato di diversi payloads (letteralmente carichi utili, rappresentati dalla strumentazione installata a bordo del drone) per effettuare misure e campionamenti nei pressi dei crateri del vulcano [Di Stefano et al., 2017]. Il drone utilizzato è un velivolo esarotore, modello DJI S800 [DJI, 2012], capace di rimanere in volo stazionario fino a 16 minuti e sollevare al decollo fino a circa 2 kg di carico utile. In particolare, attraverso una fotocamera termica ad infrarossi, installata a bordo del drone, sono stati effettuati rilievi termici in prossimità dei crateri [Di Felice et al., 2017]. Tali misure contactless si sono rivelate afflitte da errori provocati dal vapore acqueo presente in prossimità della superficie del vulcano. Da qui è nata l’esigenza di poter effettuare misure di temperatura a contatto al fine di poter operare le opportune correzioni delle misure effettuate tramite la tecnologia ad infrarossi. Lo strumento descritto, nato per essere utilizzato con il verricello di cui è dotato il drone, è stato progettato per effettuare misure di temperatura a contatto, producendo la necessaria ‘ground truth’.

Potenziamento della Rete Sismica Nazionale in Sardegna: site selection nell’area della Foresta Demaniale Fiorentini, Bultei (SS)

Vol. 400 (2018)

L’attuale copertura della Rete Sismica Nazionale (RSN) in Sardegna è costituita da quattro stazioni permanenti ubicate nella fascia orientale dell’isola che si affaccia sul mar Tirreno e da una stazione temporanea del progetto Sulcis [Anselmi et al., 2017] acquisita in tempo reale presso la sala operativa del nostro Istituto (Figura 1). Le stazioni permanenti sono installate nei comuni di Dorgali (DGI), Villasalto (VSL), Cagliari (CGL) e Aglientu (AGLI). Quest’ultima è entrata in funzione solo recentemente (marzo 2017) nella provincia di Obia-Tempio anche per la necessità di sostituire la stazione di Oschiri (OSKI), da tempo non più funzionante. L’area centro-occidentale, dalla zona del Sassarese a Nord, alle province di Oristano e dell’Ogliastra al centro, e del Campidano nella parte meridionale, sono tuttora prive di punti di osservazione. Un ampliamento della rete sarebbe importante non solo per una migliore rilevazione degli eventi lontani (telesismi) e regionali (ad es. eventi dell’Appennino), ma anche per la localizzazione della sismicità propria del blocco Sardo-Corso e dei mari circostanti. Sebbene, infatti, la Sardegna sia considerata sostanzialmente asismica, una certa attività è presente soprattutto ai bordi del blocco continentale, con magnitudo anche di rilievo come nel caso degli eventi del 26 aprile 2000 (Md 4.2 e 4.7), e 18 dicembre 2004 (ML 4.3) localizzati nel mar Tirreno centrale a circa 60 km ad est di Olbia [database ISIDe – ISIDe working group 2016]. Di recente, peraltro, due terremoti sono avvenuti in prossimità e all’interno dell’isola, rispettivamente nelle Bocche di Bonifacio, il 1 ottobre 2014 (ML 2.6) e in Gallura, il 20 ottobre 2015 (ML 2.8) [Cimini et al., 2016]. Il manifestarsi di questa sismicità e l’esigenza da parte della Protezione Civile di rendere più adeguato il monitoraggio sismico della Sardegna, hanno spinto alla ricerca di siti per nuove stazioni permanenti, programma iniziato con la valutazione di alcuni siti nell’Alta Gallura e la messa in opera della stazione di Aglientu. In questo rapporto tecnico si descrive l’attività svolta per la scelta di una seconda postazione nella parte centro-settentrionale della Regione, nella zona geografica approssimativamente equidistante ai siti di AGLI e DGI. L’area presa in considerazione è situata nella foresta di Fiorentini, una delle più antiche ed estese foreste demaniali della Sardegna. Si è indagata tale area in quanto, già sulla carta, offriva i requisiti fondamentali per la realizzazione di una stazione sismica di qualità [Trnkoczy et al., 2012]. Il luogo è caratterizzato, infatti, dall’assenza di fonti di disturbo importanti quali ferrovie, strade con traffico continuo, fiumi, aree di cava, zone industriali, impianti eolici, città o zone abitate in prossimità. Va inoltre considerato che il complesso forestale è costantemente presenziato, un elemento questo sempre più importante per la sicurezza delle apparecchiature contro furti, danneggiamenti e manomissioni.

Realizzazione di un sistema operativo Client-Server per la gestione di stazioni geomagnetiche remote e relativo simulatore in ambiente Unix

Vol. 399 (2018)

L’unità di acquisizione remota del sistema Mag-Net [Del Negro et al, 2002] impiega una motherboard in formato PC/104 compatibile con lo standard IBM (ISA), per questo può utilizzare ed eseguire I sistemi operativi di un normale PC. Fin dall’inizio è stato utilizzato l’MS-DOS che grazie alla sua semplicità ha permesso di risolvere molti problemi di stabilità però lasciando al software applicativo di gestione l’onere di gestire I diversi task. Ogni task si autoregola permettendo agli altri di funzionare molto similmente a ciò che accade in un sistema operativo di tipo preemptive (senza pre-rilascio) chiamato anche cooperative multitasking. Ciò comporta non pochi problemi soprattutto nella ripartizione delle risorse. Accade molto spesso che un task ostacoli un altro perchè viene sovraccaricato di lavoro. Si è deciso di ricercare una soluzione al problema della ripartizione non equa delle risorse sostituendo l’MS-DOS con un sistema operativo costruito ad hoc per un sistema di monitoraggio nello specifico per il sistema Mag-Net, multiprogrammato e con rilascio di risorse. La progettazione del nuovo sistema deve prescindere dall’hardware che può negli anni cambiare e divenire obsoleto, come è già successo più volte per I PC/104. L’utilizzo di un’architettura IBM ha permesso nel corso degli anni di velocizzare lo sviluppo software che poteva avvenire su un normale PC che diveniva un vero e proprio laboratorio di test per il sistema di gestione Mag-Net. La progettazione del nuovo sistema operativo deve poter preservare quanto più possibile tale vantaggio permettendo di velocizzare lo sviluppo utilizzando un normale personal computer. Per questo si è deciso di impiegare un ambiente simulato che sostituisse l’hardware durante lo sviluppo. Il 90% del codice sarà realizzato (come già successe in Mag-Net) in C/C++ [Sicali et al, 2016] e verrà completamente provato nell’ambiente simulato. Solo il 10% del software sarà dipendente dall’hardware, dovrà essere scritto in ASSEMBLY e provato direttamente sull’hardware. Utilizzare il C/C++ ha permesso di riutilizzare la totalità del software già scritto per il sistema Mag-Net.

Upgrade del sistema di alimentazione delle stazioni sismiche/GPS e monitoraggio remoto dei parametri elettrici

Vol. 398 (2018)

La Rete Sismica Nazionale (RSN) è composta da circa 350 stazioni multiparametriche che vengono alimentate per la maggior parte mediante sistema di alimentazione ad isola in modo da garantire una piena autonomia dal punto di vista energetico. In questo rapporto tecnico si farà riferimento esclusivamente a questo tipo di sistema. Allo stato attuale non risulta esserci una configurazione omogenea dell’impianto elettrico presente sui siti di monitoraggio e spesso, durante I mesi invernali, si va incontro a sofferenze dal punto di vista energetico. Questo rapporto tecnico suggerisce il corretto dimensionamento delle componenti elettriche e descrive l’infrastruttura hardware/software implementata per il controllo remoto dei sistemi di alimentazione.

Management, visualization and comparison of multiple hazards and risk using free software: the ByMuR tool

Vol. 397 (2018)

Nowadays, risk assessment is an essential tool for risk management and risk mitigation policies since it provides an evaluation of the risk associated to a recognized threat that can cause harm or damage to humans, their structures or the environment. Risk results from the combination of three factors (UNDRO, 1982): Risk = Hazard x Exposure x Vulnerability. In this very general framework, the hazard is a measure of the likelihood of the expected size of a dangerous phenomenon in a given target area and in a given exposure time, the exposure measures the assets that are potentially at risk (both people and structures) and the vulnerability represents the degree at which the assets may be damaged due to the hazard. Of course, this represents a simplification of the reality, which does not account for any uncertainty. Modern risk assessment is based on Probabilistic Risk Analyses (PRA), making use of probabilistic hazard analysis, fragility and loss models. Such probabilistic factors are typically combined the through Pacific Earthquake Engineering Research (PEER) formula [Cornell and Krawinkle, 2000; Der Kiureghian, 2005], which has been originally proposed for seismic risk and it has been recently proposed as a possible base for multi-risk assessments [Marzocchi et al., 2012; Selva, 2013; Mignan et al., 2014; Liu et al., 2015]. In this framework, the project called ByMuR (http://bymur.bo.ingv.it), funded by the Italian Ministry of Education, Universities and Research (Ministero dell’Istruzione, dell’Università e della Ricerca – MIUR) and lasted 4 years from November 2010 to November 2014, has been accomplished with the goal of providing a quantitative and objective method for quantifying the multi-risk for a given area. The approach is based on Bayesian inference that allows to account for both aleatory and epistemic uncertainties along all the phases of the computation, from hazard to risk (for hazards: [Selva and Sandri, 2013; Faenza et al., 2017; Sandri et al., 2016; Grezio et al., 2015; Selva et al., 2015]; for vulnerability and risk: [Selva et al., 2013; Selva et al., in prep.]; for the uncertainty treatment: [Marzocchi et al., 2015]). More specifically, the project was focused to: (i) provide a quantitative and objective general method for a comprehensive long-term multirisk analysis in a given area, accounting for inter-model epistemic uncertainty through Bayesian methodologies, and (ii) apply the methodology to seismic, volcanic and tsunami risks in Naples (Italy).

Figure 1. General scheme of all the inputs to ByMuR software for the case study of Naples. The tool handles both single and multi risk factors through a database and users can visualize or combine them to perform risk/multi-risk analysis for a selected target area.

One of the main products/results provided by the project is the homonym ByMuR software [Perfetti and Tonini, 2018], an open source tool aiming to manage, visualize and compare PRA results (e.g. risk curves, risk indexes) for different hazards, as well as, all the components of any PRA (e.g. hazard, fragilities and exposure), within a multi-risk perspective. For each component and for PRA results, epistemic uncertainty is handled through the mean and several percentiles of the community distribution (e.g., SSHAC 1997) or of the ensemble model [Marzocchi and Jordan, 2014]. The ByMuR software handles separately the probabilistic hazard assessments of different kind of hazardous phenomena, the relative fragility and loss models, exposure data, as well as the corresponding probabilistic risk results. The software manages precomputed results, which are input through standard formats and allows several post-processing of such data in order to produce ensemble hazard models and spatially aggregated results. In this report we present the implementation of the ByMuR software, by describing its features and by illustrating how it could serve the scope of supporting a multi-hazard and multi-risk analysis, as well as, for any hazard assessment. The results computed for the municipality of Naples are demonstrative of the general methodology and, at the same time, are here used to illustrate the features and usability of the ByMuR software. The case study is focused on the long-term (5, 10 and 50 years) multi-risk assessment due to volcanic (tephra fall and pyroclastic flows), seismic and tsunami hazardous phenomena.

Figure 1. General scheme of all the inputs to ByMuR software for the case study of Naples. The tool handles both single and multi risk factors through a database and users can visualize or combine them to perform risk/multi-risk analysis for a selected target area.

One of the main products/results provided by the project is the homonym ByMuR software [Perfetti and Tonini, 2018], an open source tool aiming to manage, visualize and compare PRA results (e.g. risk curves, risk indexes) for different hazards, as well as, all the components of any PRA (e.g. hazard, fragilities and exposure), within a multi-risk perspective. For each component and for PRA results, epistemic uncertainty is handled through the mean and several percentiles of the community distribution (e.g., SSHAC 1997) or of the ensemble model [Marzocchi and Jordan, 2014]. The ByMuR software handles separately the probabilistic hazard assessments of different kind of hazardous phenomena, the relative fragility and loss models, exposure data, as well as the corresponding probabilistic risk results. The software manages precomputed results, which are input through standard formats and allows several post-processing of such data in order to produce ensemble hazard models and spatially aggregated results. In this report we present the implementation of the ByMuR software, by describing its features and by illustrating how it could serve the scope of supporting a multi-hazard and multi-risk analysis, as well as, for any hazard assessment. The results computed for the municipality of Naples are demonstrative of the general methodology and, at the same time, are here used to illustrate the features and usability of the ByMuR software. The case study is focused on the long-term (5, 10 and 50 years) multi-risk assessment due to volcanic (tephra fall and pyroclastic flows), seismic and tsunami hazardous phenomena.

PyGLog: a Python software for handling GNSS metadata and log-files

Vol. 396 (2018)

We describe a software developed to handle metadata of Global Navigation Satellite System (GNSS) stations. The number of available GNSS sites in the Euro-Mediterranean and African area has grown significantly in the last decade, pushing toward the development of automatic procedures for the analysis of the raw observations. Currently >3000 stations are routinely processed at the GPS data analysis center based on the GAMIT/GLOBK software operating at INGV-Bologna. Here we describe a software, written in Python, developed with the goal of processing metadata associated with continuously operating GNSS stations. The metadata is, generally, an ASCII file associated with each station, containing information about the geodetic antenna, the receiver, the radome model and the antenna offset (distance between the phase center of the antenna and the reference point, depending on the mechanical structure of the antenna mount). Commonly, but not always, GNSS stations metadata are provided in the form of log-files, which are however most of time compiled by human operators and later made available on the web for public access. On the research side these metadata are fundamental for a proper data processing and an accurate estimate of geophysical information, and need to be converted in a particular standard format (station info file), depending on the software adopted for data reduction, with coherent information to not stall the elaboration. The check of metadata coming from a huge amount of GNSS stations from different networks is a time consuming task, which compromises the efficiency of the research job. The software presented in this work aims at automatically update the repository of thousands of station metadata files, checking the coherence of the information and creating the station info files, in different formats, needed for processing, thus requiring a minimum effort for data processing to the operators.

Generatore di segnale IRIG-B per la sincronizzazione di strumentazione scientifica attraverso l’uso del Network Time Protocol (NTP)

Vol. 395 (2018)

Ogni sistema di acquisizione ha la necessità di sincronizzare le misure prodotte allo scopo di facilitarne l’analisi [Sicali et al, 2016/B]. La sincronizzazione solitamente avviene attraverso l’uso di sistemi GNSS (Global Navigation Satellite System) e nel loro rappresentante più conosciuto il GPS. Seppur quest’ultimo, risulti essere il più versatile e universale, ciò nonostante possiede alcune limitazioni che a volte ne impediscono l’utilizzo. I problemi maggiori derivano dall’antenna utilizzata per captare il segnale radio, vero punto debole di tutto il sistema. In luoghi molto ostili potrebbe essere difficile utilizzare e mantenere un’appendice esterna come l’antenna GPS, a causa soprattutto di scariche da fulmine. Diversamente, potrebbe essere più semplice mantenere una trasmissione su fibra ottica o cavo in rame, utilizzando sistemi già presenti, collaudati e più sicuri, eventualmente mantenuti e pagati da terzi. Il sistema proposto è consigliato soprattutto per quei sistemi, che non possono gestire direttamente l’NTP (Network Time Protocol) [RFC 5905, 2010] e hanno la necessità di un segnale hardware esterno di tipo IRIG-B [IRIG-B, 2004].

Utilizzo della fotogrammetria SfM terrestre per il monitoraggio dei versanti: considerazioni sulle precisioni per applicazioni a lunga distanza

Vol. 394 (2018)

La fotogrammetria digitale Structure-from-Motion (SfM) oggi è molto utilizzata poiché permette di ottenere modelli digitali completi e ad alta precisione con operazioni semplici tanto nella fase di misura, attuata mediante una normale fotocamera ed eventualmente basata su una rete di appoggio topografico, quanto in quella di analisi dati. Si tratta di una tecnologia versatile che risulta utile sia in ambito topografico/geomorfologico [Westoby et al., 2012], sia in ambito architettonico [Teza et al., 2016]. In questo lavoro sono presentati i risultati di una campagna di misura esclusivamente terrestre, quindi realizzata senza l’ausilio di sistemi aerei quali droni, finalizzata al rilievo di un versante in zona aquilana. Lo scopo è quello di capire se sia possibile o meno realizzare monitoraggi del terreno realmente utili per misurare variazioni morfologiche mediante comparazione di modelli multitemporali ottenuti con procedure di acquisizione dati a basso costo. Tali procedure sono caratterizzate da una logistica di lavoro semplice e indipendente, senza l’uso di punti di controllo a terra (Ground Control Points, GCPs), tenendo ben presente il fatto che, in condizioni di emergenza, un rilievo terrestre è fortemente vincolato alla accessibilità delle aree su cui è possibile camminare ed alla visuale spesso ostruita dalla presenza di vegetazione. Si sottolinea pertanto che la valenza del lavoro si riferisce essenzialmente al monitoraggio rapido e in presenza di fattori ostativi all’uso di GCPs, anche se alcuni dei risultati ottenuti riguardo alla risoluzione e alla scelta di una particolare fotocamera rispetto ad un’altra hanno validità generale. È infatti di particolare interesse comprendere quale sia la risoluzione spaziale realmente ottenibile, la quale dipende dall’ottica della camera utilizzata per gli scatti e dalla distanza di lavoro, ma anche dalla copertura raggiungibile da osservazioni terrestri. È chiaro che, nel quadro di un monitoraggio libero e a basso costo, si tratta altresì di valutare le prestazioni, in termini di bontà dei modelli fotogrammetrici ottenuti, di fotocamere di fascia medio-alta ma non necessariamente di tipo professionale. Si parla cioè di apparecchi acquistabili con cifre contenute in alcune centinaia di euro e non migliaia. Per questo lavoro sono state utilizzate due fotocamere digitali di produzione Nikon: la D3300 e la Coolpix P520. Inoltre, per avere un riferimento stabile e preciso per scopi di confronto e validazione dei risultati, è stato utilizzato un laser scanner terrestre (TLS) long range Optech ILRIS-ER [Optech, 2017]. Il presente lavoro si aggiunge, completandole, alle esperienze precedenti condotte presso la sezione di Bologna dell’INGV e inerenti al confronto SfM e TLS [Pesci et al., 2015; Teza et al., 2016], all’ottimizzazione del numero di scatti fotografici [Pesci e Teza, 2016], alla valutazione della risoluzione del modello fotogrammetrico in funzione del pixel a terra [Pesci et al., 2016a] e alla valutazione dei risultati ottenibili con fotocamere diverse ma compatibili [Pesci et al., 2016b].

Integration of heterogeneous data, software and services in Solid Earth Sciences: the EPOS system design and roadmap for the building of Integrated Core Services

Vol. 393 (2018)

Understanding Earth systemic processes is critically important to support a safe and sustainable modern society. Volcanic eruptions, earthquakes, floods, landslides, tsunamis, weather, and global climate change are all Earth phenomena impacting citizens life and the way governments and nations are organized and managed. Accessing data and information describing such phenomena is not trivial due to the a) scattered nature of infrastructures providing access to the data and b) heterogeneity of data, protocols and methods used to obtain, analyse and process data [Bailo D. and Jeffery K.G., 2014]. In this context, EPOS1 (European Plate Observing System) intend to provide a substantial contribution by facilitating the process of obtaining and integrating data, data products, services and software (DDSS) for Solid Earth science generated and provided by monitoring networks, observing systems and facilities belonging to European countries. EPOS will bring together Earth scientists, national research infrastructures, ICT (Information & Communication Technology) experts, decision makers, and general public to develop new concepts and tools for accurate, durable, and sustainable answers to societal questions concerning geohazards and those geodynamic phenomena (including geo-resources) relevant to the environment and human welfare. DDSS provided by more than 200 Research Infrastructures will be integrated under a central, single but distributed Infrastructure – the so called Integrated Core Services – by establishing an e-platform where access, use and reuse of heterogeneous data (in terms of format, metadata and accessibility) and associated software, services and resources is easy and transparent. EPOS will use new e-science opportunities to create a pan-European infrastructure for Solid Earth science that will support a safe, innovative and sustainable society. EPOS project has been coordinated since the beginning by INGV. The EPOS Implementation Phase (IP) started in 2014 following the completion of the Preparatory Phase (2010-2014). Running until 2019, EPOSIP it has two major milestones. Firstly, the Implementation Phase project2 which is funded under the European Commission’s Horizon 2020 programme and which runs from 2015 to 2019. Secondly, the establishment of the EPOS European Research Infrastructure Consortium (ERIC) which will see EPOS becoming a legal entity3. Key objectives of the Implementation Phase project are: implementing Thematic Core Services (TCS), the domain-specific service hubs for coordinating and harmonizing national resources/plans with the European dimension of EPOS; building the Integrated Core Services (ICS) to provide a novel research platform to different stakeholders; designing the access to distributed computational resources (ICS-D); ensuring sustainability and governance of TCS and EPOS-ERIC. The research infrastructures (RIs) that EPOS is coordinating include: i) distributed geophysical observing systems (seismological and geodetic networks); ii) local observatories (including geomagnetic, near-fault and volcano observatories); iii) analytical and experimental laboratories; iv) integrated satellite data and geological information services; v) new services for natural and anthropogenic hazards; vi) access to geoenergy test beds. In this context, the purpose of this report is to provide a description of the EPOS technical infrastructure as a whole, and introduce the reader to the technical details and procedures required to achieve the integration between data providers and EPOS main platform. Readers can find an explanation of the several acronyms in the appendix at the end of this work.

The environmental characterization of Lake Vättern and the AUV test for the Clean Sea project

Vol. 392 (2018)

Clean Sea (Continuous Long-term Environmental and Asset iNtegrity monitoring at SEA) project [Gasparoni et al., 2013a] concerns the use of commercially AUV [Gasparoni et al., 2013b] with a modular interchangeable payload for environmental monitoring and inspection tasks around Eni oil & gas offshore infrastructures. The

platform identified for the development of the project was SAAB Seaeye Sabertooth. The project defined peculiar hardware and software architecture, where the payload controller is separate from the AUV controller and able of modifying “in real time” the mission strategy [Buffagni et al., 2014]. The environmental payload chosen for AUV was: Temperature [°C], Salinity [psu], Methane [μmol/l], Colored Dissolved Organic Matter [ppb], Chlorophyll [μg/l], Turbidity [m-1 sr-1], Oxygen [μmol], Oxygen [%], Polycyclic Aromatic Hydrocarbons [μg/l], pH, Oxidation Reduction Potential [mV]. The Lake Vättern (Figure 1), the sixth largest lake in Europe and the second largest lake in Sweden after Lake Vänern, has been chosen as test field for the first AUV ascertainment. In detail, 36 tests have been realized in two different sites (Figure 1), located in the North-East (latitude 58°32’32.27”N, longitude 14°58’9.03”E) and North-West (latitude 58°32’32.27”N, longitude 14°58’9.03”E) side of the Lake, from November, 2012 to July 2013.

platform identified for the development of the project was SAAB Seaeye Sabertooth. The project defined peculiar hardware and software architecture, where the payload controller is separate from the AUV controller and able of modifying “in real time” the mission strategy [Buffagni et al., 2014]. The environmental payload chosen for AUV was: Temperature [°C], Salinity [psu], Methane [μmol/l], Colored Dissolved Organic Matter [ppb], Chlorophyll [μg/l], Turbidity [m-1 sr-1], Oxygen [μmol], Oxygen [%], Polycyclic Aromatic Hydrocarbons [μg/l], pH, Oxidation Reduction Potential [mV]. The Lake Vättern (Figure 1), the sixth largest lake in Europe and the second largest lake in Sweden after Lake Vänern, has been chosen as test field for the first AUV ascertainment. In detail, 36 tests have been realized in two different sites (Figure 1), located in the North-East (latitude 58°32’32.27”N, longitude 14°58’9.03”E) and North-West (latitude 58°32’32.27”N, longitude 14°58’9.03”E) side of the Lake, from November, 2012 to July 2013.

WebGIS EMERSITO: un sistema informativo geografico per la condivisione delle informazioni in situazioni di emergenza sismica

Vol. 391 (2018)

Durante l’emergenza sismica nel centro Italia a seguito dell’evento del 24 agosto 2016, il gruppo EMERSITO (Gruppo per lo studio degli effetti di sito in emergenza) trasversale all’INGV (Istituto Nazionale di Geofisica e Vulcanologia) ha partecipato attivamente alle campagne di acquisizione dati nei luoghi dell’evento. Lo scopo principale del gruppo EMERSITO è quello di svolgere e coordinare le campagne di monitoraggio per gli effetti di sito a seguito di eventi sismici di forte magnitudo o che hanno provocato danneggiamenti attribuibili a fenomeni di amplificazione del moto sismico in superficie. Per lo svolgimento delle proprie attività, in campagna e in sede, è di rilevante importanza la possibilità di consultazione e di condivisione delle informazioni sui luoghi dell’evento, recuperate o già in possesso dei vari componenti del gruppo. Questa condivisione, vista l’afferenza del personale del gruppo all’interno di diverse sezioni ma anche la sua dislocazione in diverse sedi distribuite nell’intero territorio nazionale (Roma, Milano, L’Aquila, Grottaminarda (AV), Arezzo), non è facilmente realizzabile in modo semplice ed efficiente. Per soddisfare l’esigenza di scambio e di condivisione delle informazioni utili allo studio delle aree colpite dal sisma e anche dei dati relativi alle attività in campagna, come ad esempio le posizioni e le caratteristiche delle stazioni delle reti sismiche e accelerometriche temporanee installate e dei dati relativi alla sismicità in tempo reale, in un modo che fosse il più possibile semplice ed efficace, EMERSITO si è avvalso di un sistema di tipo webGIS preparato appositamente (vedi capitolo 2. Il webGIS di EMERSITO), che ha permesso la gestione delle informazioni controllata tra tutti i membri del gruppo e che ha anche dato la possibilità di scambiare dati, in tempo reale, con altri gruppi impegnati nella stessa emergenza. Il webGIS è utile nelle operazioni di pianificazione per l’installazione delle stazioni sismiche in emergenza in quanto consente di avere un quadro generale della rete EMERSITO e delle altre possibili reti installate con altri obiettivi sempre nell’area colpita dal terremoto. Infatti è possibile mettere in condivisione le informazioni sulle reti introducendo nel progetto uno strato informativo per ogni rete e quindi conoscere le informazioni aggiornate sulle reciproche installazioni. Il webGIS, inoltre, è stato adottato per condividere le informazioni ottenute dall’analisi di dati sismologici della Rete Sismica Nazionale (RSN) oppure di altre reti. Tra le informazioni condivise vi sono le misure delle massime accelerazioni del suolo (PGA - Peak Ground Acceleration) indotte dal terremoto Mw 6.0 del 24 agosto 2016 registrate dagli accelerometri dei vari siti della RAN (Rete Accelerometrica Nazionale), divulgate dal Dipartimento di Protezione Civile (DPC) e utilizzate per le prime stime sull’entità e la distribuzione del danno. Infine è un ottimo strumento per la rapida produzione di immagini da inserire in report sullo stato di avanzamento delle attività di emergenza del gruppo [Cultrera G. et. al, 2016)] e di come queste attività sono in relazione con l’andamento della sequenza.

Precisione e accuratezza nella determinazione dei costituenti maggiori in soluzione acquosa mediante cromatografia ionica: stime per i cromatografi Dionex ICS-1100 utilizzati presso la Sezione INGV di Palermo

Vol. 390 (2018)

La Cromatografia Ionica (IC) è diventata una delle tecniche analitiche più utilizzate nella determinazione degli anioni (F-, Cl-, Br-, NO3-, SO42-) e dei cationi (Li+, Na+, K+, Mg2+, Ca2+) in soluzioni acquose, anche a basse concentrazioni. Nel Laboratorio dell’INGV Sezione di Palermo questa tecnica viene utilizzata per determinare la composizione chimica di acque naturali (acque sotterranee, termali, meteoriche, marine), di fluidi fumarolici, campionati tramite il metodo delle ampolle di Giggenbach e delle specie acide emesse dai pennacchi vulcanici campionati con trappole alcaline. Ogni anno nel laboratorio vengono analizzati numerosi campioni per scopi di ricerca e monitoraggio geochimico e ambientale. Uno dei principali problemi dell’attività analitica di routine è la valutazione della precisione del dato, definita dall’American Public Health Association [1999], “come la misura del grado di accordo tra analisi replicate di un campione, di solito espresse come deviazione standard”. Tralasciando I problemi di rappresentatività del campione, ci sono diversi fattori che contribuiscono alla precisione, come il pretrattamento del campione, la preparazione e conservazione delle miscele di calibrazione, la ripetibilità delle misure delle aree dei picchi delle miscele di calibrazione e il tipo di calibrazione. In questo lavoro mostriamo la precisione dei cromatografi Dionex ICS-1100 ripetendo più volte l’analisi le miscele di calibrazione durante una singola sessione analitica, e la ripetibilità dello strumento, elaborando I risultati ottenuti analizzando le stesse miscele di calibrazione in differenti sessioni analitiche nell’arco di 12 mesi. Infine, viene determinata l’accuratezza del metodo attraverso l’analisi di un campione certificato. L’accuratezza è la vicinanza tra il valore osservato ed il valore vero, o comunque accettato come tale. I dati riportati in questo rapporto tecnico si riferiscono alle condizioni analitiche per le analisi di routine, con la configurazione strumentale corrente in uso presso questo laboratorio; queste possono essere ottimizzate per altri range di utilizzo a condizione però che vengano eseguite le necessarie verifiche di precisione e accuratezza.

Fase preliminare di un esperimento per valutare la risoluzione dei modelli SfM

Vol. 389 (2017)

Il lavoro qui descritto riguarda le esperienze realizzate nel tentativo di fornire informazioni a priori sulla risoluzione ottenibile mediante rilievi con fotogrammetria Structure-from-Motion (SfM). Si è cercato di capire se sia o meno possibile ottenere un valore di soglia utile a mettere in relazione la dimensione del pixel a terra con il dettaglio misurabile nel modello finale a partire dalla sola conoscenza delle caratteristiche delle camere utilizzate, dalla geometria del rilievo e in particolare dalla distanza di lavoro. Per fare ciò è stato realizzato un target, in questo caso bidimensionale, e fotografato col consueto approccio utilizzato in fotogrammetria, da varie distanze. Per ciascuna distanza, le immagini catturate sono state elaborate per ricavarne nuvole di punti ispezionabili ed estrarre informazioni sulla dimensione dei più piccoli dettagli in esse presenti. Il lavoro è stato realizzato con la finalità di trovare una relazione empirica che possa indicare la risoluzione della nuvola di punti in funzione della distanza di acquisizione e quindi del pixel a terra. Nelle esperienze precedenti attuate alle sezione di Bologna dell’INGV sono stati ottenuti i seguenti risultati salienti: 1) il rilievo SfM, se eseguito correttamente, è confrontabile con quello ottenuto mediante laser scanner terrestre (TLS) [Pesci et al., 2015; Teza et al., 2016]; 2) al di sopra di un certo numero di scatti fotografici il risultato non cambia, ossia un’eccessiva quantità di immagini non comporta alcun beneficio in termini di risoluzione [Pesci e Teza, 2016]; 3) la risoluzione dipende dalla distanza di lavoro, ossia la dimensione del pixel a terra è il parametro principale da tenere in considerazione [Pesci et al., 2016a]; 4) i modelli SfM ottenuti da camere con caratteristiche diverse ma compatibili portano a risultati confrontabili e molto simili tra loro [Pesci et al., 2016b]. Da questi risultati di base si è partiti per realizzare un esperimento ad hoc e tentare di valutare la risoluzione ottenibile in partenza solo in riferimento alla distanza di lavoro, s’intende utilizzando i rigorosi criteri per le misure già abbondantemente descritti nelle esperienze precedenti.

Gas Gauge System - Sistema di controllo delle batterie al piombo per l’Osservatorio geomagnetico di Lampedusa

Vol. 388 (2017)

In molti sistemi di monitoraggio, come gli osservatori remoti e le stazioni di misura di parametri geofisici, geochimici o altro, si utilizzano batterie, gruppi di continuità (UPS) e pannelli solari, sia per fornire una adeguata alimentazione, là dove non è disponibile la rete elettrica, che per garantire una continuità di funzionamento della strumentazione. In particolare, nei siti in cui vi sono esclusivamente sistemi fotovoltaici, le batterie vengono sfruttate con cicli continui di carica e scarica e quindi sono soggette ad un inevitabile e progressivo deterioramento. Conoscere lo stato delle batterie è quindi fondamentale per un corretto funzionamento di tutta la strumentazione. Lo Stato Di Carica (SOC) misurato in percentuale dalla sua capacità, è un parametro fondamentale per capire lo stato di una batteria. Infatti, al termine di un ciclo di carica, il SOC indica esattamente il livello di efficienza di una batteria. Il metodo più semplice per misurarlo è controllare il voltaggio della batteria, ma è una soluzione poco affidabile. Infatti, nel caso in cui la componente chimica di una batteria sia in via di deterioramento e l’accumulatore è posto sotto carica, la tensione può comunque portarsi ad un buon livello, mentre lo stato di carica potrebbe non essere al 100%. Inoltre, all’aumentare della temperatura, aumenta il voltaggio a circuito aperto, mentre a basse temperature la tensione della batteria diminuisce. In queste condizioni quindi, la misura del voltaggio può indicare uno stato di carica errato e la batteria non renderà la sua vera capacità. Un metodo migliore per la misura del reale stato di carica di una batteria è la misura continua della sua corrente, integrata nel tempo. In questo modo, attraverso cicli di carica e scarica completa, è possibile verificare lo stato di una batteria misurandone la carica accumulata e rilasciata. Questa operazione può essere eseguita anche durante il suo normale funzionamento, ma potrebbe alla lunga condurre a risultati falsati per le perdite di potenza per effetto Joule. Un altro metodo è l’“impedance track” o “fuel gauge” della Texas Instruments (gas gauge o fuel gauge è infatti lo strumento che indica il livello del carburante in un serbatoio). Il metodo, implementato in un algoritmo, utilizza l'impedenza dell'accumulatore misurata dalle sue celle come chiave fondamentale per calcolare la capacità residua. L'impedenza viene misurata e memorizzata in tempo reale come una funzione dello stato di carica. Il profilo di impedenza in tempo reale, con le misure in tensione a circuito aperto (OCV), permettono il calcolo della curva di scarica dell'accumulatore. In fase di carica e scarica, l'algoritmo utilizza il metodo della misura di corrente integrata nel tempo (columb counting), mentre in modalità passiva (senza correnti di carica e scarica) l'algoritmo sfrutta le misure in tensione a circuito aperto (OCV) per calcolare lo stato di carica in qualsiasi condizione di funzionamento.

Determinazione della composizione isotopica del deuterio su campioni acquosi a diversa salinità tramite spettroscopia ad assorbimento laser e analizzatore elementare ad alta temperatura

Vol. 387 (2017)

In natura esistono tre isotopi dell’idrogeno: prozio, deuterio e trizio rispettivamente con la notazione isotopica 1H, 2H e 3H. I primi due sono isotopi stabili, il terzo, il trizio è un isotopo radioattivo. Il prozio è l’isotopo dell’idrogeno più abbondante in natura con un’abbondanza pari a circa 99.985% ed è l’unico a non possedere neutroni essendo composto da un solo protone attorno al quale gira un elettrone. Il secondo isotopo per abbondanza in natura è il deuterio con una abbondanza pari a circa 0.015%. Quest’ultimo presenta nel nucleo un protone ed un neutrone. La quantificazione del rapporto isotopico tra due isotopi dello stesso elemento è molto importante perché permette di distinguere se due molecole dello stesso composto, con le stesse caratteristiche chimiche, hanno avuto origini diverse. Il rapporto isotopico ® tra prozio e deuterio, o più in generale tra due isotopi, viene calcolato dal rapporto tra l’isotopo più raro su quello più abbondante, per l’idrogeno R=2H/1H. Poiché gli R isotopici hanno un numero elevato di decimali (es. 2H/1H= 0,000160025) è stato deciso dalla comunità scientifica di evitare di usare valori assoluti di R e di impiegare un valore relativo ottenuto dal rapporto isotopico tra il materiale da analizzare contro il rapporto isotopico di uno materiale di riferimento moltiplicato per un fattore di 103. Questo nuovo valore viene indicato come δ‰. L’analisi isotopica è molto importante in una serie di campi di ricerca che spazia dalle scienze ambientali a quelle forensi. In campo geochimico lo studio della composizione isotopica dell’idrogeno, insieme a quella dell’ossigeno, può fornire informazioni sul processo di formazione delle acque naturali. In alcuni casi anche la sola determinazione del δ2H può fornire utili indicazioni su processi naturali, come dimostrato da Nakamura et al., [2008] sullo studio dei processi di degassamento in aree vulcaniche. Gli isotopi dell’idrogeno vengono anche utilizzati in campo biochimico come “traccianti” nello studio dei meccanismi delle varie reazioni chimiche e metaboliche che si verificano nel corpo. I rapporti isotopi dell’idrogeno, ma non solo, vengono anche utilizzati in enologia per verificare la provenienza geografica di un vino, considerata una caratteristica importante dei prodotti vitivinicoli sia per I consumatori che per la normativa internazionale. La tecnica più diffusa ed utilizzata per la determinazione dei rapporti isotopici dell’idrogeno oggi in commercio è la tecnica di spettrometria di massa o IRMS (Isotope-Ratio Mass Spectrometry). Tutt’oggi, con il progresso tecnologico, sono state inserite in commercio tecniche laser che lavorano nel campo dell’infrarosso per la determinazione dei rapporti isotopici. Già in un precedente lavoro di Oliveri [2015] è stata discussa l’affidabilità di queste strumentazioni per la determinazione del δ180 su acque ad elevata salinità. Il presente lavoro tende a completare quanto fatto precedentemente, confrontando I valori di composizione isotopica dell’idrogeno ottenuti su una serie di campioni salini analizzati attraverso tecnica ICOS Off-axis (Integrated Cavity Output Spectroscopy Off-Axis) e EA-IRMS (Elemental Analysis - Isotope Ratio Mass Spectrometry). I valori di δ2H misurati sono stati comparati al fine di accertare I limiti strumentali dei nuovi strumenti su campioni a elevata salinità, problematici per le tecniche laser. Lo spettrofotometro ad assorbimento e lo spettrometro di massa utilizzati sono rispettivamente il DLT-100 prodotto dalla Los Gatos Research e il Delta XP della Thermo Scientific connesso ad un analizzatore elementare (TC/EA) tramite un’interfaccia (Conflo IV). Entrambe le strumentazioni sono disponibili nei laboratori della sezione di Palermo dell’Istituto Nazionale di Geofisica e Vulcanologia.

La Scheda Stazione elettronica: un sistema informatico di raccolta e condivisione delle informazioni sulla composizione e la configurazione delle stazioni in campagne di acquisizione dati

Vol. 386 (2017)

Il presente Rapporto Tecnico descrive un sistema informatico di ausilio alle operazioni di installazione e di manutenzione delle reti mobili. Nel seguito si cerca di fare una semplice analisi delle criticità che possono emergere in questo tipo di operazioni e di condividere le soluzioni pensate, sviluppate e impiegate recentemente nell’emergenza sismica in Italia centrale (Amatrice, agosto-dicembre 2016) nel lavoro di campagna all’interno del gruppo EMERSITO (Gruppo per lo studio degli Effetti di Sito in Emergenza). Nasce dall’esperienza diretta nelle campagne di acquisizione dati e dalle difficoltà connesse vissute; non è da ritenersi un manuale d’uso del sistema, il quale può essere trattato separatamente, ma solo un modo per metterne in evidenza l’esistenza e quelle che ritengo essere la sua utilità. Nella costruzione di reti mobili per esperimenti o in situazioni di emergenza è buona norma definire e ben identificare le stazioni che le compongono tramite una descrizione completa di tutti i componenti, così come tenere memoria delle eventuali modifiche apportate alle stesse durante tutto il loro periodo di funzionamento. Ogni stazione di una rete ha un inizio (l’installazione e start), un ciclo di vita più o meno lungo (tutto il suo tempo di permanenza) durante il quale può subire modifiche e una fine (la sua disinstallazione). Oltre alle informazioni strettamente legate alla strumentazione impiegata è utile e a volte necessario prendere nota di altri dati relativi al sito quali: le fonti di rumore vicine, le strutture in prossimità, il tipo di suolo sul quale è installata la stazione, i contatti utili e la logistica, le foto, etc. Le schede stazioni utilizzate per la raccolta delle informazioni sono utili durante il periodo di permanenza delle reti per controllare l’andamento funzionale di ogni singola stazione e per individuare le principali criticità che nel tempo possono affliggere la rete. Una buona stesura delle schede stazioni contribuisce ad alleggerire e rendere più efficiente sia il lavoro di campagna sia, successivamente, quello di trattamento e pre-analisi dei dati. Il sistema realizzato permette la creazione e la gestione di Schede Stazioni in formato elettronico, con le quali è possibile raccogliere tutte le informazioni tramite dispositivi portatili quali smartphone e tablet ma anche con pc. La classica scheda stazione cartacea è stata informatizzata e riprodotta in tutte le sue parti; è stata arricchita di tutte quelle caratteristiche e funzionalità tipiche dei dispositivi informatici mobili. I dati inseriti relativi alle installazioni e ai controlli delle stazioni vengono raccolti tramite un’applicazione e inviati ad un punto di raccolta e di sincronizzazione su Internet che li organizza e li rende disponibili per vari scopi.

Analisi preliminare dei dati acquisiti dalla rete sismica mobile Fiumenet installata nel settore orientale della faglia della Pernicana-Provenzana (Mt. Etna, Italia)

Vol. 385 (2017)

Il sistema strutturale Provenzana-Pernicana, ubicato nel versante nord-orientale del Monte Etna, rappresenta uno dei lineamenti tettonici più attivi del vulcano. Secondo le conoscenze di letteratura [Azzaro et al., 1998a; Alparone et al., 2012], la prosecuzione orientale di tale sistema di faglie è caratterizzata da un basso tasso di accadimento di terremoti e da movimenti di creep asismico, che talvolta producono danni ai manufatti esistenti (strade, case, autostrade, gasdotti, ecc.). Allo scopo di migliorare la capacità di indagine della rete sismica permanente, gestita dall’Istituto Nazionale di Geofisica e Vulcanologia – Osservatorio Etneo - Sezione di Catania – (INGV-OE), e studiare con dettaglio la sismicità del prolungamento orientale di questo sistema di faglie, è stata realizzata l’installazione di una rete sismica locale composta da sei stazioni prossime alla struttura. Una rete locale consente di localizzare terremoti anche di bassa energia, utili sia nelle attività di sorveglianza e monitoraggio [e.g. Rapisarda et al., 2009; Moretti et al., 2010; Castellano et al., 2012] che di ricerca [e.g. Gambino et al., 2009]. La rete sismica mobile, costituita da stazioni digitali equipaggiate con sensori tre-componenti, opererà per un periodo medio-lungo (1÷2 anni) allo scopo di verificare l’eventuale presenza di attività microsismica del sistema strutturale investigato, non rilevabile dall’attuale rete permanente. Lo scopo di questo lavoro è quello di illustrare gli aspetti tecnici relativi all’installazione di questa rete sismica mobile e di effettuare una prima analisi dei dati registrati nel periodo compreso tra ottobre e dicembre 2015.

Implementazione del Sistema Embedded per l’Osservatorio multidisciplinare di Portopalo di Capopassero

Vol. 384 (2017)

Il lavoro presentato in questo articolo descrive lo sviluppo del sistema operativo embeddedd dell’osservatorio di fondo mare di Portopalo di Capopassero e rappresenta lo step successivo rispetto a quanto introdotto in [Giovanetti et al., 2017]. Il sistema operativo embedded ospiterà il software di acquisizione, i tools di gestione e la sincronizzazione temporale. In particolare, analizzeremo le fasi di implementazione del sistema operativo embedded, realizzate attraverso l’uso di diversi prodotti della Xilinx1. Per lo sviluppo è stato utilizzato un host con sistema operativo Linux. Il lavoro è stato realizzato su Ubuntu 14.04 LTS (64 bit) con installata la suite Xilinx Vivado 2014.4 e il toolchain Petalinux 2014.4, descritti di seguito.

Migrazione dei server di acquisizione dalle stazioni remote nelle infrastrutture per il calcolo a elevate prestazioni (HPC)

Vol. 383 (2017)

Si è approfittato della la diffusione capillare e dell’abbassamento massiccio dei costi dei sistemi di calcolo ad elevata efficienza (HPC) per ammodernare i server di acquisizione e archiviazione presenti nei centri di acquisizione dati [Del Negro et al., 2002]. Il sistema descritto nel testo è stato applicato con successo oltre al sistema Mag-Net [Del Negro et al., 2002] anche alla rete dilatometrica [Sicali & Bonaccorso, 2013]. L’ammodernamento dei due sistemi di monitoraggio, nonostante interessasse sia la parte hardware che software, è stato poco invasivo poiché entrambi i sistemi possiedono una struttura modulare [Sicali et al., 2016]. L’ammodernamento ha permesso di risolvere problemi oramai decennali come il posizionamento dei sistemi di acquisizione rispetto ai server di acquisizione, ottimizzando allo stesso tempo le risorse disponibili, sia computazionali che umane. La manutenzione è divenuta più semplice e meno dispendiosa in termini di tempo e costi. L’uso delle tecniche di virtualizzazione ci permette di manipolare a piacimento i sistemi e automatizzare alcune procedure altrimenti realizzabili solo intervenendo fisicamente. La possibilità di astrarre le componenti hardware degli elaboratori al fine di renderle disponibili al software in forma di risorsa virtuale, ci permette di eseguire operazioni che un tempo erano invasive, potenzialmente dannose oltre che dispendiose in termini di tempo (time consuming). Si pensi ad operazioni come la rimozione/sostituzione del disco fisso, della CPU o all’upgrade della RAM.